1 Zugangsknoten bestehend aus:

SUN Fire V40z

2 Prozessoren AMD Opteron 248 (2,2 GHz)

4 GByte Hauptspeicher

2

SCSI Platte 73 GB

1 CDROM-Laufwerk

2 Gigabit-Ethernet-Adapter (auf Mainboard)

2

Gigabit-Ethernet-Adapter

1 Fibre-Channel-Adapter (2 Gbit/s)

1 InfiniBand-Adapter

(Hochgeschwindigkeits-Netzwerk, 10 Gbit/s)

1 Serviceprozessor

ZIDcluster2004 - gut Ding braucht Weile

Die Turbulenzen um das neue Clustersystem ( "Phoenix aus der Asche" - phoenix.zserv ) wurden mit der Installation und der erfolgreichen Abnahme des SUN-Clusters

Ende August 2005 beigelegt. Mit der Aufnahme des Testbetriebes wurde nach

einigen Softwareanpassungen begonnen, das System läuft stabil und zufrieden

stellend.

Hardwarekonponenten

65 Stück Clusterknoten (compute nodes) bestehend aus:

SUN Fire V20z

2 Prozessoren AMD Opteron 250 (2,4 GHz)

4 GByte Hauptspeicher

1 SCSI Platte 73 GB

1 CDROM-Laufwerk

2 Gigabit-Ethernet-Adapter (auf Mainboard)

1 InfiniBand-Adapter

(Hochgeschwindigkeits-Netzwerk, 10 Gbit/s)

1 Serviceprozessor

SUN Fire V20z

2 Prozessoren AMD Opteron 250 (2,4 GHz)

4 GByte Hauptspeicher

1 SCSI Platte 73 GB

1 CDROM-Laufwerk

2 Gigabit-Ethernet-Adapter (auf Mainboard)

1 InfiniBand-Adapter

(Hochgeschwindigkeits-Netzwerk, 10 Gbit/s)

1 Serviceprozessor

1 Fileserver bestehend aus:

IBM e325

2 Prozessoren AMD Opteron 246 (2,0 GHz)

4 GByte Hauptspeicher

2 SCSI Platte 73 GB

1 CDROM-Laufwerk

2 Gigabit-Ethernet-Adapter (auf Mainboard)

1 Fibre-Channel-Adapter (2 Gbit/s)

IBM e325

2 Prozessoren AMD Opteron 246 (2,0 GHz)

4 GByte Hauptspeicher

2 SCSI Platte 73 GB

1 CDROM-Laufwerk

2 Gigabit-Ethernet-Adapter (auf Mainboard)

1 Fibre-Channel-Adapter (2 Gbit/s)

Clusterweites Storage: SGI TP9300

(zentrales FibreChannel Storage System)

(2 Gbit FC, redundant am Fileserver und

am Zugangsknoten angebunden)

(zentrales FibreChannel Storage System)

(2 Gbit FC, redundant am Fileserver und

am Zugangsknoten angebunden)

Sonstiges:

3 Stück 19"-Systemschränke inkl. Powerswitches

HP MSL6030, LTO2 Backup-Library

(am Fileserver angeschlossen)

3 Stück 19"-Systemschränke inkl. Powerswitches

HP MSL6030, LTO2 Backup-Library

(am Fileserver angeschlossen)

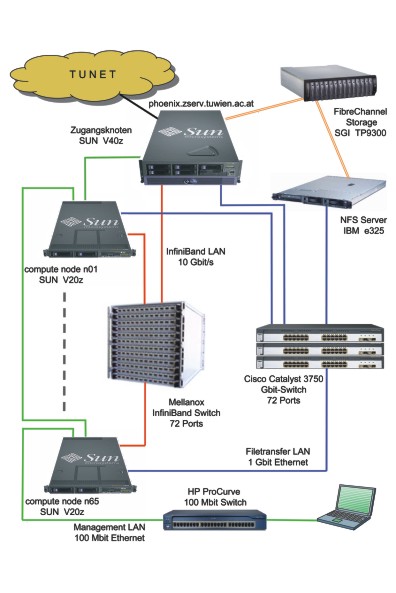

Konfiguration ZIDcluster2004

AMD Opteron Processor Architecture

Clusterknoten Verkabelung

Netzwerk

Hochgeschwindigkeits-Netzwerk:

1 Stück MST14000 Mellanox InfiniBand-Switch

(InfiniBand 10 Gbit/s; 72 Ports, max. 144 Ports)

1 Stück MST14000 Mellanox InfiniBand-Switch

(InfiniBand 10 Gbit/s; 72 Ports, max. 144 Ports)

Filetransfer-Netzwerk:

3 Stück Cisco Catalyst 3750, stackable

(Gbit-Ethernet-Switch), 72 Ports

3 Stück Cisco Catalyst 3750, stackable

(Gbit-Ethernet-Switch), 72 Ports

Management-LAN:

1 Stück HP ProCurve 2626

(100 Mbit-Ethernet-Switch, 24 Ports)

1 Stück HP ProCurve 2626

(100 Mbit-Ethernet-Switch, 24 Ports)

TUNET-Zugang:

Gbit-Anbindung über den Zugangsknoten

Gbit-Anbindung über den Zugangsknoten

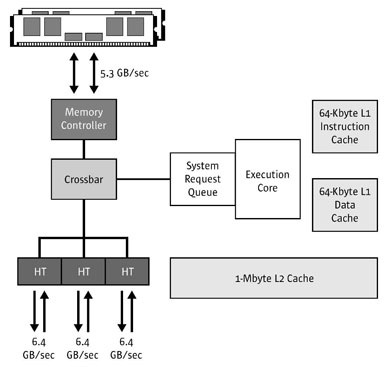

Systembeschreibung SUN Fire V20z

Das Kernstück des Clustersystems bildet der compute-node SUN Fire V20z,

ein symmetrisches Multiprozessorsystem auf x86-Basis mit 2 AMD Opteron-CPUs.

Diese Systeme sind rack-optimiert und nur 1U (1.69 inch/ 43 mm) hoch. Die

AMD-Opteron CPU verfügt im Gegensatz zu "klassischen" Intel-Architekturen

nicht über die Kopplung der CPU über die Northbridge zum Memory, es ist

im Gegensatz dazu auf dem Chip ein integrierter Memory-Controller vorhanden,

der die Anbindung von DDR1 Memory Modulen mit 128 Bit Breite ermöglicht.

Ein wesentlicher Bestandteil der CPU-Architektur ist die Anbindung weiterer

CPUs und der I/O-Systeme über den HyperTransport. Dieser 16 Bit breite

und mit 800 MHz getaktete serielle Bus erlaubt eine Übertragungsrate bis

zu 3,2 GB/s pro Richtung (Bandbreite 6,4 GB/s).

Das I/O-Subsystem ist über einen HyperTransport Link angeschlossen, es

wird ein so genannter HyperTransport PCI-X Tunnel eingesetzt, der einen

HyperTransport I/O Hub, 2 Gbit-Ethernet-Controller und einen SCSI-Controller

versorgt.

Ein integrierter Serviceprozessor, der über 2x 10/100 Mbit Ethernet-Anschlüsse

verfügt, erlaubt das Management der Clusterknoten "Out-of-Band", d. h. es

steht ein eigenes Management-LAN zur Verfügung. Da es sich bei diesen Ethernet-Anschlüssen

um einen 3-Port Switch handelt, können die Clusterknoten direkt zusammengeschaltet

werden; der Verkabelungsaufwand reduziert sich beträchtlich.

Die AMD64-Architektur erlaubt es, vorhandene 32-Bit Applikationen und Betriebssysteme

zu verwenden. Durch die Auslegung aller Register auf 64 Bit Breite ist

es möglich, "echte" 64-Bit Applikationen unter einem 64-Bit Betriebssystem

zu entwickeln.

Netzwerke - Zusammenschaltung der Clusterknoten und Anbindung an das TUNET

Zur Kopplung der Clusterknoten und zum Anschluss an das lokale Netz der

TU Wien sind vier unabhängige Netzwerke installiert:

-

Hochgeschwindigkeits-Netzwerk:

MPI-Kommunikation (InfiniBand, 10 Gbit/s, full duplex, siehe ZIDline Nr. 12) -

Filetransfer- und Datennetzwerk:

NFS, Kommunikation zwischen den Knoten

(1 Gbit/s Ethernet) -

Management-LAN:

Clustermanagement, 100 Mbit/s -

TUNET-Anschluss:

phoenix.zserv.tuwien.ac.at (1 Gbit/s)

Zugangsknoten

Der Zugangsknoten ist ein System SUN Fire V40z, das sowohl über einen Gbit-Anschluss

zum TUNET verfügt wie auch in alle anderen Kommunikationsnetze eingebunden

ist. Dieses System ist ebenfalls ein Doppel- prozessorsystem (gleiche Systemarchitektur

wie die V20z), verfügt jedoch über wesentlich mehr PCI-Steck- plätze und

kann mit maximal 4 CPUs (AMD Opteron) bestückt werden.

Fileserver

Ein Fileserver (IBM 325) ist in das Gbit-Netz eingebunden und stellt die

Home-Directories der User über NFS zur Verfügung. An diesem Fileserver

ist ein RAID-Set eines zentralen FibreChannel Storage (SGI TP9300, 2 Gbit/s

FC) angeschlossen, derzeit stehen ca. 2 TByte zur Verfügung. Der Zugangsknoten

ist ebenfalls mit einer FC-Verbindung an das Storage angeschlossen, um

eventuelle Systemausfälle rasch bereinigen zu können.

Betriebssystem, Compiler und Batchsystem

Als Betriebssystem ist Linux Fedora Core 3 im Einsatz, auf die Installation

von RedHat Enterprise AS wurde aufgrund der inakzeptablen Preise für dieses

Produkt verzichtet.

Als Clustersoftware steht das "Cluster Development Kit" von Portland Group

zur Verfügung, neben den PGI Compilern (Fortran, C und C++) steht die Compilersuite

von PathScale und der Intel Compiler zur Verfügung (siehe Artikel auf Seite

10).

Als Batchsystem steht die SUN Grid Engine zur Verfügung.

Management-Software

Für das Clustermanagement sind neben einer Reihe von selbst entwickelten

Scripts die Produkte NAGIOS und als Datensammel- und Darstellungssystem

GANGLIA im Einsatz.

Das Finanzierungsmodell

Das vorgesehene Rückfinanzierungsmodell wurde nach intensiven Gesprächen

zwischen der Universitätsleitung, dem FWF und dem ZID den geänderten Gegebenheiten

angepasst. Für TU-interne Forschungsprojekte sowie für die Nutzung des

Clusters für Lehrveranstaltungen ist keine Direktfinanzierung durch das

betroffene Institut erforderlich. Ebenso werden FWF-Projekte, sollten die

für die Rechenzeit beantragten finanziellen Mittel nicht bewilligt werden,

nicht direkt verrechnet.

Es wird eine Nachverrechnung (wie für alle Applikationsserver) erfolgen,

die Account-Daten werden jährlich an die Universitätsleitung übermittelt

und ein Teil der angefallenen Kosten (Investitionen abgeschrieben auf drei

Jahre, kein Betriebs- und Personalaufwand) über die Budgetzuteilung an

die Fakultäten rückverrechnet.

Für die Verrechnung werden für jeden User zwei unterschiedliche Kennzahlen

herangezogen:

- für interaktive Jobs am Zugangsknoten: CPU-Zeiten

- Jobs, die über das Queueing-System abgesetzt werden: (endtime - starttime) * Anzahl der reservierten CPUs (slots)

Folgende Kosten werden nach Ende des Testbetriebes (ab 1. 1. 2006) verrechnet:

Für TU-interne Forschungsprojekte:

- Euro 0,1 für die interaktive CPU-Stunde

- Euro 0,1 für die "Clusterstunde" pro CPU

Projekte aus dem Drittmittelbereich werden im vollen Umfang (inkl. Raum-

und Personalkosten) direkt mit den Instituten verrechnet:

- Euro 0,13 für die interaktive CPU-Stunde

- Euro 0,13 für die "Clusterstunde" pro CPU

Links

ZID Phoenix Cluster:

http://www.zserv.tuwien.ac.at/phoenix/

SUN Microsystems: http://www.sun.com/

AMD: http://www.amd.com/

HyperTransport Consortium: http://www.HyperTransport.org/

Mellanox: http://www.mellanox.com/

InfiniBand Trade Association: http://www.infinibandta.org/

SUN Microsystems: http://www.sun.com/

AMD: http://www.amd.com/

HyperTransport Consortium: http://www.HyperTransport.org/

Mellanox: http://www.mellanox.com/

InfiniBand Trade Association: http://www.infinibandta.org/