Finite Elemente und Strömungsdynamik

Eine Erfolgsgeschichte

Der Einsatz von (meist) kommerziellen Softwareprodukten aus den Bereichen

Finite Elemente und Strömungsdynamik zieht sich wie ein roter Faden durch

die Geschichte der verschiedenen Computersysteme an der TU Wien. Der Kauf

des neuen IBM-Clustersystems (icp5.zserv) stellt bereits die 10. Generation

von Computersystemen dar, auf denen diese Softwarepakete zum Einsatz kommen,

und zeigt damit den hohen Stellenwert dieser Anwendungen für Forschung

und Lehre.

Wie alles begann

Im Jahre 1978 wurden auf dem System CDC CYBER 74 die Programmpakete SAP

4 und NONSAP installiert (UC Berkeley, Berechnung von Tragwerken mit Hilfe

der FE-Methode) und damit der erste Schritt zur Nutzung dieser Verfahren

gesetzt. Diese Pakete (erweitert durch das Programmpaket STRESS der Uni

Laibach) waren bis zum Abbau der CDC CYBER-Anlagen im Jahre 1992 in Verwendung.

Das FE-Paket ADINA wurde 1988 auf der CDC CYBER 180-860 lizenziert.

Im Jahre 1988 wurden am Interuniversitären EDV-Zentrum (IEZ) an der TU

Wien auf einem System NAS AS/9160 (ein Mainframesystem von Hitachi mit

einer Vektorunit, 16 MB Hauptspeicher und einer floating-point Leistung

von 17 MFlop/s) die FE-Pakete ABAQUS und ADINA installiert und für Festigkeitsberechnungen

eingesetzt.

Die Installation des ersten Vektorrechners im Jahre 1990 (Siemens/Fujitsu

VP50-EX mit 128 MB Hauptspeicher und einer floating-point Leistung von

238 MFlop/s) ermöglichte eine deutliche Ausweitung des Softwareangebots

auf drei FE-Pakete (ABAQUS, ADINA und NISA II) und ein Softwarepaket für

Strömungsdynamik (FIDAP).

Nach der Auflösung des IEZ und der Gründung des neuen EDV-Zentrums der

TU Wien im Jahre 1991 endete auch die Ära der Mainframes, das Fachbereichsrechner-Konzept

führte zur Installation der Systeme Convex C3220 und des "Fachbereichrechners

Maschinenbau" (IBM RS 6000-950 und 550). Dadurch konnten zu den bestehenden

weitere FECFD-Pakete wie ANSYS, EMAS, NASTRAN, MARC lizenziert werden.

Die Ausweitung des Kooperationsvertrags zwischen der TU Wien und der Firma

Siemens ermöglichte im Jahre 1992 den Austausch der VP50 auf einen Vektorrechner

Siemens/Fujitsu S100 mit der ca. 3,5-fachen Leistung. Auf diesem System

kam das Strömungspaket FIRE zum Einsatz, das vor allem in der Automobilindustrie

(Motorenbau) verwendet wurde.

Der erste Applikationsserver FECFD

Im Jahre 1995 ging die Ära der Fachbereichsrechner zu Ende und wurde durch

das "Applikationsserver-Konzept" abgelöst. Kernaussagen dieses EDV-Konzepts,

das in den wesentlichen Zügen auch heute noch gültig ist (und sich bestens

bewährt hat), sind:

- für bestimmte Applikationen optimale Hardware- und Systemarchitekturen zur Verfügung zu stellen,

- deutlich höhere Performance (Memory und Massenspeicher) als Institutssysteme,

- kostengünstige Lizenzierung teurer kommerzieller Softwarepakete.

Einer der ersten Applikationsserver, der entsprechend diesem Konzept angekauft

wurde, war 1995 der "Applikationsserver für Finite Elemente und Strömungsdynamik".

Dieses System der Firma Digital (DEC 8200 mit 2 CPUs und 2 GB Memory) wurde

schrittweise ausgebaut und erweitert, sodass im Jahre 1998 der FECFD-Cluster

bestehend aus zwei Maschinen (DEC 8200 und DEC 8400 mit insgesamt 12 CPUs

und 16 GB Hauptspeicher) und den Software-Paketen ABAQUS, ANSYS, MARC,

EMAS, FLUENT, FIDAP und CFX zur Verfügung stand.

Im Jahre 2002 wurde als Nachfolgesystem ein Clustersystem der Firma HP/Compaq

gekauft (HP SC45-Cluster), das über 10 Knoten (ES 45 mit je 4 CPUs und

16 GB Memory), ein gemeinsames Disk-Storage (2,6 TB) und eine schnelle Kopplung

(Quadrics, 360 MByte/s) verfügte. Dieses Clustersystem mit 40 CPUs unter

dem Betriebssystem TRU64 UNIX verfügt auch bis zum heutigen Tag über gute

Leistungswerte sowohl in Bezug auf die Rechenleistung (DEC-alpha CPUs mit

1 GHz) als auch auf die Clustersoftware (gemeinsames Filesystem, Batch-

und Queue-Management, schnelle Kopplung, gutes Clustermanagement) und erfüllt

heute vor allem im Bereich der Lehre wertvolle Dienste.

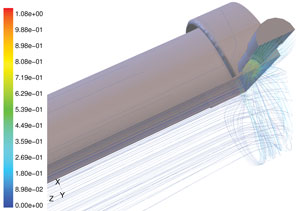

Wandfilmausdehnung im Einlasstrakt (Anwendung FIRE)

Aus: M. Klepatsch: Simulation der Mehrphasenströmung im Motor, Projekte an den zentralen Applikationsservern, Berichte 1997, EDV-Zentrum, TU Wien

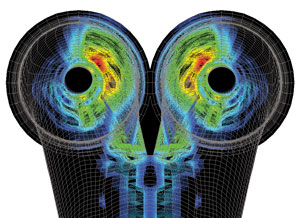

Strömungslinien im Sekundärkreis eines Hämodialyse-Moduls (berechnet mit FLUENT 5.1).

Aus: M. Harasek, Das CDF-Paket FLUENT, ZIDline 2, Dezember 1999.

Das Diagramm zeigt die Entwicklung der CPU-Leistung der Systeme vom Jahr

1993 bis 2006 am Beispiel des ABAQUS-Standardbenchmarks STD-T4 (gemessene

Laufzeiten auf den installierten Systemen in Sekunden).

Der neue ZID-Cluster 2006 - FECFD

Im Frühjahr des vergangenen Jahres wurde mit der Planung einer Ersatzanschaffung

für den über 3 Jahre alten Applikationsserver für Finite Elemente und Strömungsdynamik

(SC45-Cluster) begonnen. Ausschlag- gebend für diese Neuplanung war, dass

für einen Großteil der installierten kommerziellen FECFD-Softwarepakete

in naher Zukunft keine Updates und neue Versionen für das Betriebssystem

TRU64 UNIX zur Verfügung stehen werden.

Im Jänner 2006 wurde eine EU-weite öffentliche Ausschreibung durchgeführt

(maximaler Finanzrahmen € 380.000,- für die Rechnerhardware, für das Gesamtprojekt

standen in Summe € 450.000,- zur Verfügung).

Die Veröffentlichung dieser Ausschreibung erfolgte am 13. Jänner 2006.

Nach einer intensiven Prüfung der Angebote wurde am 5. April 2006 der Firma

EDV-Design Informationstechnologie Ges.m.b.H. der Zuschlag für ein Clustersystem

von IBM (POWER5+ Prozessoren) erteilt.

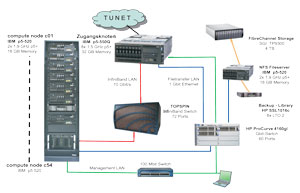

Die Cluster- und Hardwarearchitektur

Die Clusterknoten (Zugangsknoten und Compute-Nodes, Fileserver, Backup-Library

und alle Netzwerkkomponenten) sind in 6 Schränken (19 Zoll) installiert.

Alle 54 Compute-Nodes sind 4U-hohe Systeme mit 2 Prozessoren IBM POWER5+

(Dual-Core Module) mit 1,9 GHz Taktrate und 16 GB Hauptspeicher, der Zugangsknoten

(fat node) verfügt über 8 CPUs IBM POWER5+ (2x Quad-Core Module) mit 1,5 GHz

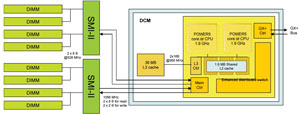

und 32 GB Memory. Das 2-Core p-520 System Planar enthält ein Dual-Core Module

(DCM) und das lokale Memory-Subsystem.

Systemname: icp5.zserv.tuwien.ac.at

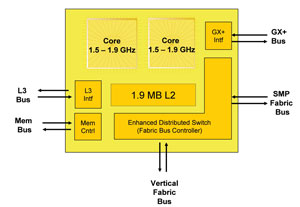

Das DCM enthält die beiden Prozessorkerne (1,9 GHz), den gemeinsamen L2

Cache (1,9 MB) und die Verbindung zum L3 Cache (36 MB, 30,4 GB/s Bandbreite).

Der Chip ist in 90 nm CMOS-Technologie gefertigt und enthält Schnittstellen-Bausteine

wie einen Memory- Controller, einen horizontalen und vertikalen Fabric

Bus für den SMP-Support sowie eine GX+ Schnittstelle für I/O-Devices.

Das Memory-Subsystem besteht aus 8 Memory-Bänken (DDR2), die über 2 SMI-II

Controller mit einer Bandbreite von 21 GB/s mit dem DCM verbunden sind.

Die I/O-Schnittstelle ist der GX+ Controller, der über einen Enhanced I/O-Controller

einen GX+ Port und 4x PCI-X Buses mit einer Bandbreite von 5 GB/s ansteuert.

An diesem GX+ Port ist der InfiniBand Host Bus Adapter (HBA) angeschlossen.

Für die schnelle Kopplung der Clusterknoten mit MPI wird 4x InfiniBand

(10 Gbit/s full duplex) von der Firma TOPSPIN (Cisco) eingesetzt. Für den

interaktiven Zugang und den Filetransfer steht ein Gbit-LAN zur Verfügung.

Drei Lizenzserver (ausfallssicher in drei Gebäuden aufgebaut) verteilen

die erforderlichen Applikations-Software-Lizenzen auf die Clusterknoten.

Installation, Abnahme und Benutzer-Testbetrieb

Der geplante Installationstermin im Mai 2006 konnte leider nicht eingehalten

werden, da knapp vor der Auslieferung der Systeme eine technische Änderung

der Konfiguration von IBM durchgeführt wurde (InfiniBand-Karte nicht am

PCI-X sondern am GX+ Bus). Dadurch und durch eine sehr späte Lieferung

des InfiniBand-Switches wurde die Installation erst Ende August 2006 abge-

schlossen.

Nach der erfolgreichen Abnahme (Leistungstest und 4-wöchiger Dauertest)

wurde der Testbetrieb gestartet, die erforderlichen Anpassungen der Software-Pakete

durchgeführt und das Queueing-System an die Betriebserfordernisse angepasst.

Leider traten nach einigen Wochen Software-Probleme im Bereich InfiniBand

auf, die nur durch die Einschaltung des IBM-Labors in Austin gelöst werden

konnten. Das System läuft seit einigen Wochen (unter Hochlast) ohne Probleme.

Der Benutzer-Testbetrieb wird immer mehr ausgeweitet. Wir gehen davon aus,

dass zum Jahreswechsel die Migration aller Benutzer des SC-Clusters auf

das neue System abgeschlossen sein wird.

Die Systembetreuung wird von Josef Beiglböck (42071, beiglboeck@zid.tuwien.ac.at)

und Dietmar Sonnleitner (42087, sonnleitner@zid.tuwien.ac.at) durchgeführt.

Weitere Informationen im Web: http://www.zserv.tuwien.ac.at/icp5/