ZIDcluster2004 - auf ein Neues

In der letzten Ausgabe der ZIDline vom Dezember 2004 haben wir vom Zuschlag

für ein Hochleistungs-Clustersystem (ZIDcluster2004) berichtet. Der Zuschlag

wurde der Firma Siemens Business Services GmbH (SBS) für ein Clustersystem

hpcLine von Fujitsu-Siemens für 50 Clusterknoten (2 CPUs AMD Opteron 250,

4 GB Hauptspeicher) und 2 Zugangsknoten erteilt. Für die Kopplung der Clusterknoten

war ein Myrinet-Netzwerk (2 Gbit/s) vorgesehen.

Die Lieferung und Installation des Systems wurde Anfang Jänner 2005 rasch

und problemlos durchgeführt, die ersten Leistungstests auf den Einzelknoten

verliefen ohne nennenswerte Probleme und erbrachten die zugesagten Leistungswerte.

Mitte Februar traten auf einzelnen Clusterknoten Hardwareprobleme auf (zumindest

hatte es in dieser Testphase den Anschein, als würden einzelne Komponenten

defekt sein), sodass laufend Hardware-Komponenten und sogar ganze Knoten

ausgetauscht wurden.

Die Situation verschlechterte sich dramatisch, wir mussten erkennen, dass

es sich nicht um "einfache Hardwareprobleme" handelt, sondern um gravierende

Stabilitätsprobleme der Knoten bei hohen Lastanforderungen (sowohl hohe

CPU- wie auch Netzwerklast). Vor allem bei großen MPI-Jobs (z.B. Linpack-Benchmark

über alle Knoten) mussten wir feststellen, dass Knoten nicht mehr ansprechbar

waren ("einfrieren") oder sich selbst "rebooteten".

Eine Erklärung dieser Instabilitäten konnte weder von den Spezialisten

von Tyan (dem Boardhersteller), von Myricom noch von Fujitsu-Siemens gefunden

werden.

Nach einigen Wochen intensiver Fehleranalyse wurde uns von SBS Wien ein

Angebot zum Austausch des Clusters unterbreitet, da eine weitere Zeitverzögerung

sowohl vertraglich als auch wirtschaftlich nicht mehr akzeptabel war. Angeboten

wurde die Installation eines Clustersystems der Firma SUN bestehend aus

folgenden Komponenten:

64 Stück Clusterknoten (compute nodes) bestehend aus:

2 Prozessoren AMD Opteron 250 (2,4 GHz)

4 GByte Hauptspeicher

1 SCSI Platte 73 GB

1 CDROM-Laufwerk

2 Gigabit-Ethernet-Adapter (auf Mainboard)

1 InfiniBand-Adapter

(Hochgeschwindigkeits-Netzwerk, 10 Gbit/s)

1 Serviceprozessor

4 GByte Hauptspeicher

1 SCSI Platte 73 GB

1 CDROM-Laufwerk

2 Gigabit-Ethernet-Adapter (auf Mainboard)

1 InfiniBand-Adapter

(Hochgeschwindigkeits-Netzwerk, 10 Gbit/s)

1 Serviceprozessor

1 Stück Zugangsknoten bestehend aus:

Basisausstattung wie Clusterknoten, zusätzlich

2 Gigabit-Ethernet-Adapter

1 Fibre-Channel-Adapter (2 Gbit/s)

2 Gigabit-Ethernet-Adapter

1 Fibre-Channel-Adapter (2 Gbit/s)

Hochgeschwindigkeits-Netzwerk:

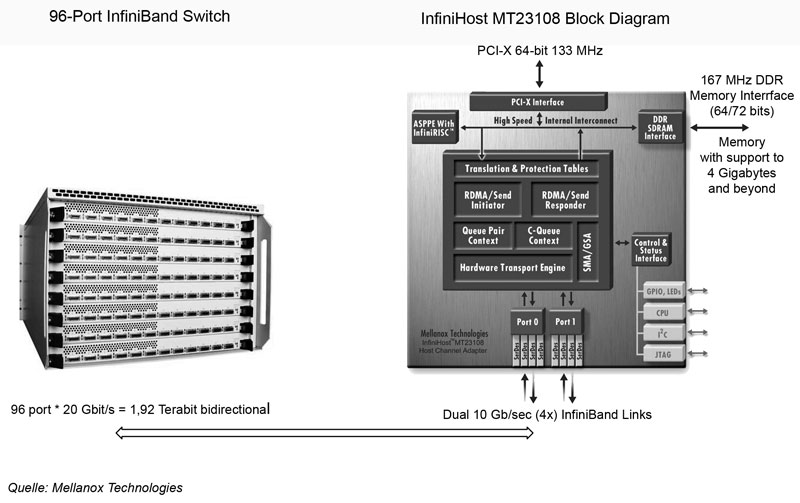

InfiniBand-Switch (96 Ports)

InfiniBand-Switch (96 Ports)

Filetransfer-Netzwerk:

3 Stück Gbit-Ethernet-Switch, 24 Ports

3 Stück Gbit-Ethernet-Switch, 24 Ports

Management-LAN:

3 Stück 100Mbit-Ethernet-Switch, 24 Ports

3 Stück 100Mbit-Ethernet-Switch, 24 Ports

3 Stück 19"-Systemschränke inkl. Terminalserver

Als Kopplungsnetzwerk wird für den Filetransfer Gbit-Ethernet eingesetzt,

für die Kopplung der Knoten für die Parallelisierung wird InfiniBand (von

der Firma Mellanox) mit einer Datenrate von 10 Gbit/s eingesetzt.

Vorgesehen ist ein 96-Port InfiniBand Switch, sodass die volle Bandbreite

zwischen allen Clusterknoten zur Verfügung steht. Das System wird in 3

Systemschränken geliefert, für das Clustermanagement sind die Knoten über

Terminalserver und einem eigenen Management-LAN (100 Mbit/s Ethernet) zusammengeschaltet.

Als Betriebssystem wird aller Voraussicht nach RedHat Enterprise AS zum

Einsatz kommen, als Clustersoftware steht das "Cluster Development Kit"

von Portland Group zur Verfügung. Neben den PGI Compilern (Fortran, C

und C++) wird die Compilersuite von PathScale zur Verfügung stehen.

Als Batchsystem steht neben Torque (ein Ressource und Queue Management

System, das auf OpenPBS basiert) die SUN Grid Engine zur Verfügung.

Dieses Angebot wurde von uns angenommen, wir erwarten die Lieferung des

Gesamtsystems Mitte Juli 2005.

Wir bedauern die Zeitverzögerung. Die kostenneutrale Erhöhung der Anzahl

der Knoten auf 64 Compute-Nodes ist als Kompensation der Technologie- und

Leistungsentwicklung der letzten Monate zu betrachten.

InfiniBand is a powerful new architecture designed to support I/O connectivity for the Internet infrastructure. InfiniBand is supported by all the major OEM server vendors as a means to expand beyond and create the next generation I/O interconnect standard in servers. InfiniBand is backed by top companies in the industry, including the steering committee members: Compaq, Dell, Hewlett Packard, IBM, Intel, Microsoft, and Sun. In total, there are more than 220 members of the InfiniBand Trade Association.

Anpassung des Finanzierungsmodells

Das vorgesehene Rückfinanzierungsmodell wurde nach intensiven Gesprächen

zwischen der Universitätsleitung, dem FWF und dem ZID den geänderten Gegebenheiten

angepasst. Für TU-interne Forschungsprojekte sowie für die Nutzung des

Clusters für Lehrveranstaltungen ist keine Direktfinanzierung durch das

betroffene Institut erforderlich. Ebenso werden FWF-Projekte, sollten die

für die Rechenzeit beantragten finanziellen Mitteln nicht bewilligt werden,

nicht direkt verrechnet.

Es wird eine Nachverrechnung (wie für alle Applikationsserver) erfolgen,

die Account-Daten werden jährlich an die Universitätsleitung übermittelt

und ein Teil der angefallenen Kosten (Investitionen abgeschrieben auf drei

Jahre, kein Betriebs- und Personalaufwand) über die Budgetzuteilung an

die Fakultäten rückverrechnet.

Projekte aus dem Drittmittelbereich werden im vollen Umfang direkt mit

den Instituten verrechnet.