TU Wien |

ZID |

ZIDline 11 | ZIDcluster2004

ZIDcluster2004

Der neue Hochleistungs-Cluster

Peter Berger

Der ZID wird für das numerisch intensive Rechnen ein neues Clustersystem

betreiben.

Die Nutzung soll durch begutachtete Projekte mit Kostenbeteiligung

erfolgen.

Bereits im Jahre 2003 wurden umfangreiche Diskussionen und Gespräche mit

der Universitätsleitung und den Hauptbenutzergruppen der TU Wien zum Themenschwerpunkt

"Numerisch intensives Rechnen auf zentralen Hochleistungsservern" durchgeführt.

Die Fragestellung, ob und in welcher Dimensionierung ein Nachfolgesystem

für die bestehenden, nicht mehr zeitgemäßen Systeme (unser "schnellstes

System", die IBM SP (hal.zserv) wurde Mitte 2001 in Betrieb genommen) ausgeschrieben

werden kann, wurde unter der Bedingung eines Rückfinanzierungsmodells positiv

entschieden. Als maximaler Finanzrahmen für ein Hochleistungs-Clustersystem

wurden uns für dieses Projekt EUR 350.000,- zur Verfügung gestellt.

Nach der Erarbeitung der technischen Anforderungen wurden in Zusammenarbeit

mit den Nutzern die Spezifikationen für eine EU-weite, öffentliche Ausschreibung

für ein Clustersystem erstellt. Diese Ausschreibung wurde von der Bundesbeschaffung

GmbH im Auftrag des ZID durchgeführt. Von sieben Firmen wurden Angebote

abgegeben, die Anbotseröffnung erfolgte am 28. September 2004.

Nach einer intensiven Prüfung der Angebote wurde am 10. November 2004 der

Zuschlag der Firma Siemens Business Services GmbH für ein Clustersystem

hpcLine von Fujitsu-Siemens für folgende Systemkomponenten erteilt:

|

50 Stück Clusterknoten bestehend aus

2 Prozessoren AMD Opteron 250 (2,4

GHz)

4 GByte Hauptspeicher

1 Platte SATA 120GB

1 CDROM-Laufwerk

2 Gigabit-Ethernet-Adapter

(auf Mainboard)

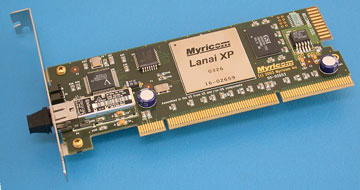

1 Myrinet-Adapter

(Hochgeschwindigkeits-Netzwerk, 2Gbit/s)

1

Management-Board

2 Stück Zugangsknoten bestehend aus:

Basisausstattung wie Clusterknoten,

zusätzlich

2 Gigabit-Ethernet-Adapter

1 Fibre-Channel-Adapter (2 Gbit/s)

Hochgeschwindigkeits-Netzwerk:

Myrinet-Switch (56 Ports)

Management-Board

Filetransfer-Netzwerk:

Gbit-Ethernet-Switch, 24 Ports

Gbit-Ethernet-Switch,

48 Ports

2 Systemschränke (19 Zoll)

|

Das Hochleistungs-Netzwerk

Entscheidend für die Leistungsfähigkeit eines Clusters ist das Kopplungsnetzwerk

zwischen den Clusterknoten. In der Ausschreibung wurde zwei getrennte Netzwerke

gefordert:

-

ein Gigabit-Netzwerk für den Zugriff auf Benutzerdateien (Filetransfer-Netzwerk,

z.B. über NFS) und für das Clustermanagement,

-

ein schnelles Kopplungsnetzwerk über alle Clusterknoten für die Parallelisierung

mit MPI.

Das bestellte Clustersystem verfügt pro Clusterknoten über 2 Gigabit-Ethernet-Anschlüsse,

die über 2 Stück Gigabit-Switches (über 10 GB/s uplink gekoppelt) zusammengeschaltet

werden und für das NFS-Netzwerk und das Clustermanagement zur Verfügung

stehen.

Die Kopplung der Clusterknoten für die Parallelisierung wird über ein Myrinet-Hochgeschwindigkeitsnetzwerk

realisiert.

Was ist Myrinet?

Bereits im Jahr 1994 wurden von der Firma Myricom (www.myricom.com) die

ersten Cluster-Interconnect-Komponenten installiert (basierend auf einem

ANSI/- VITA-Standard), einem Netzwerk mit hoher Datenrate, geringer Latenzzeit

und hoher Verfügbarkeit. Die Entwicklung wurde stetig vorangetrieben und

hat sich in den letzten Jahren im Clusterbereich marktführend etabliert.

Von den Supercomputern, die im November 2004 in der TOP500-Liste aufgelistet

sind, verwenden 193 Systeme (38,6 %) Myrinet.

Die Leistungsmerkmale von Myrinet-2000:

full-duplex 2+2 Gb/s Datenrate

flow control, error control und "heartbeat"

zur Überwachung aller Links

hohe Bandbreite bei geringer Latenz:

Sustained

one-way data rate for large messages 495 MByte/s

Sustained two-way data rate

for large messages 770 MByte/s

Latency for short messages 5.71 ms

low level

message-passing protocol (GM oder MX)

Glasfaserverbindungen zu den Hostadaptern

Host Adapter und Switch-Komponenten

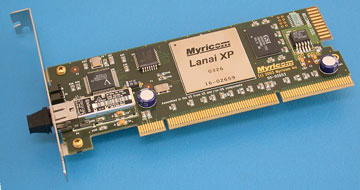

Jeder Clusterknoten wird mit einer Myrinet/PCI-X Interfacekarte ausgestattet

(PCI-X 64 bit 133 MHz, 2MB local memory, single-port, LC optical connector,

low- profile).

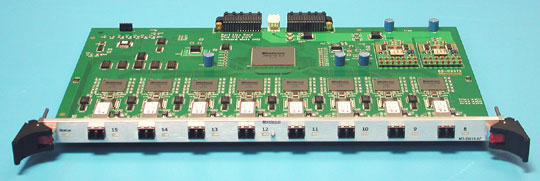

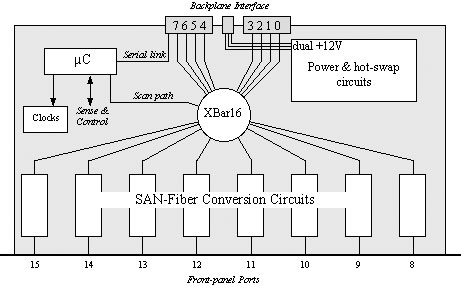

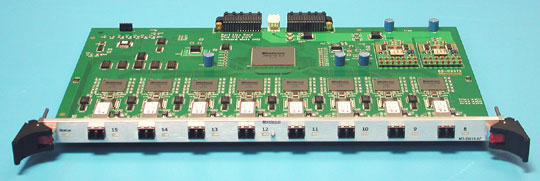

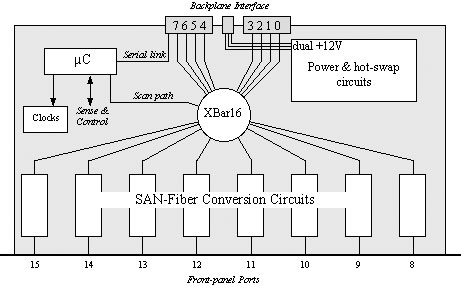

Ein Myrinet-2000-Switch für maximal 64 Hostports wird für die Verbindung

der Clusterknoten untereinander eingesetzt, in unserer Konfiguration bestehend

aus 7 Line-Cards mit je 8 Fiberanschlüssen.

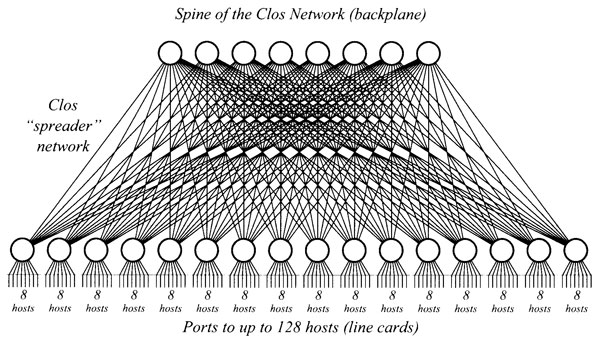

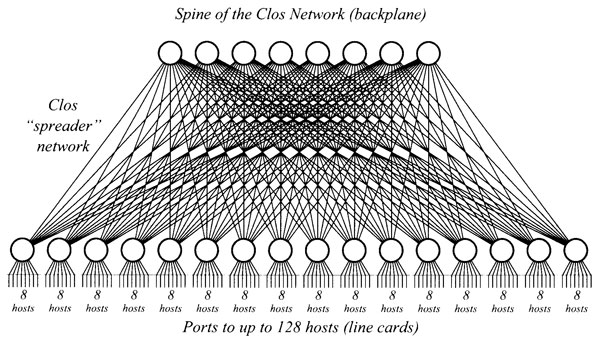

Um bei maximal 64 Hosts optimale Verbindungen zwischen den Hosts herzustellen,

wird eine "Clos Network Topologie" (Charles Clos veröffentlichte 1953 ein

Papier "A Study of Non-Blocking Switching Networks") eingesetzt. Kern dieser

Technologie ist ein 16-Port Myrinet Crossbar Switch (Xbar16 single chip),

der jeweils die 8 Hostports mit der Backplane verbindet, auf der sich wiederum

"spine switches" befinden.

System- und Managementsoftware

Als Betriebssystem wird Linux (SUSE oder RedHat) zum Einsatz kommen, als

Clustersoftware steht das "Cluster Development Kit" von Portland Group

zur Verfügung.

PGI Cluster Development Kit

Das PGI Cluster Development Kit (CDK) enthält die gesamte Software, die

für Software-Entwicklung und Cluster-Verwaltung benötigt wird:

-

PGI Compiler (Fortran, C, C++)

-

Unterstützung von Fortran-95-Erweiterungen

-

Unterstützung von IBM/DEC/Cray-eigenen Erweiterungen von Fortran 77

-

Grafische MPI und OpenMP Debugging und Profiling Tools

-

MPICH-Bibliotheken und -Tools

-

Torque Resource Management und Queueing System

-

ScaLaPack-Bibliotheken (parallele mathematische

Bibliotheken)

-

Optimierte BLAS- und LaPack-Bibliotheken

-

Tutorials und Beispiele, um rasch eigene Codes auf Basis von HPF, OpenMP

oder MPI entwickeln zu können.

-

Volle 64-Bit-Unterstützung für AMD-Opteron-Prozessoren (SSE/SSE2, Prefetching,

Verwendung der zusätzlichen Register, 64-Bit-Adressierung)

-

Kompatibilität zu gcc, g77 und gdb

-

Automatische Thread-basierte Parallelisierung mit PGF77, PGF90 und PGCC

MPICH ist eine (vom Argonne National Laboratory entwickelte) Open-Source-Implementierung

des Message-Passing-Interface(MPI-)-Standards. MPICH enthält eine voll-

ständige Implementierung der Version 1.2 des MPI-Standards sowie signifikante

Teile von MPI-2, speziell im Bereich der parallelen I/O-Unterstützung.

Torque ist ein Resource und Queue Management System, das auf OpenPBS basiert.

Gegenüber OpenPBS wurden zahlreiche Verbesserungen und Erweiterungen eingebaut.

Clustermanagement-Software

Jeder Clusterknoten ist mit einem Management-Board (Qlogic Zircon) ausgestattet,

das über das "Intelligent Platform Management Interface" (IPMI) und das

"Remote Management and Control Protocol" (RMCP) das Management und die

Überwachung der Clusterknoten ermöglicht.

Das Rückfinanzierungsmodell

Wie bereits in der Einleitung dargelegt, wurden uns die finanziellen Mittel

von der Universitätsleitung nur unter der Bedingung zur Verfügung gestellt,

dass ein Rückfinanzierungsmodell (gerechnet über drei Jahre) für das neue

Clustersystem erstellt wird.

Da es nicht sinnvoll erscheint, als Maßeinheit für massiv parallele Jobs

die CPU-Zeiten der Clusterknoten zu verrechnen, wird jene Zeitspanne als

"Verrechnungseinheit" herangezogen, in der der Job die angeforderten CPUs

blockiert, d. h. wenn er in der Queue den Status run erhält, bis zum Job-Ende.

Als Verrechnungseinheiten dienen "Clusterstunden" für 32, 64 oder 100 Prozessoren,

die tatsächlichen Kosten werden in allen Fällen projektspezifisch abzustimmen

sein.

Für die Programmentwicklung und für die Lehre wird sicherlich ein Sockelbetrag

ohne Verrechnung von Kosten zur Verfügung stehen.

Zeitplan

Die Installation des Gesamtsystems ist noch in diesem Jahr vorgesehen,

der Cluster wird von der Firma Siemens schrankweise vollständig zusammengebaut

geliefert und am ZID aufgestellt.

Wir sind zurzeit dabei, die erforderlichen Feinabstimmungen vorzunehmen

und werden die Installation, die Abnahme und die Aufnahme des Produktionsbetriebs

so rasch wie möglich durchführen.

Seitenanfang | ZIDline 11 - Dezember 2004 | ZID | TU Wien